특징

AI 워크로드 가속화

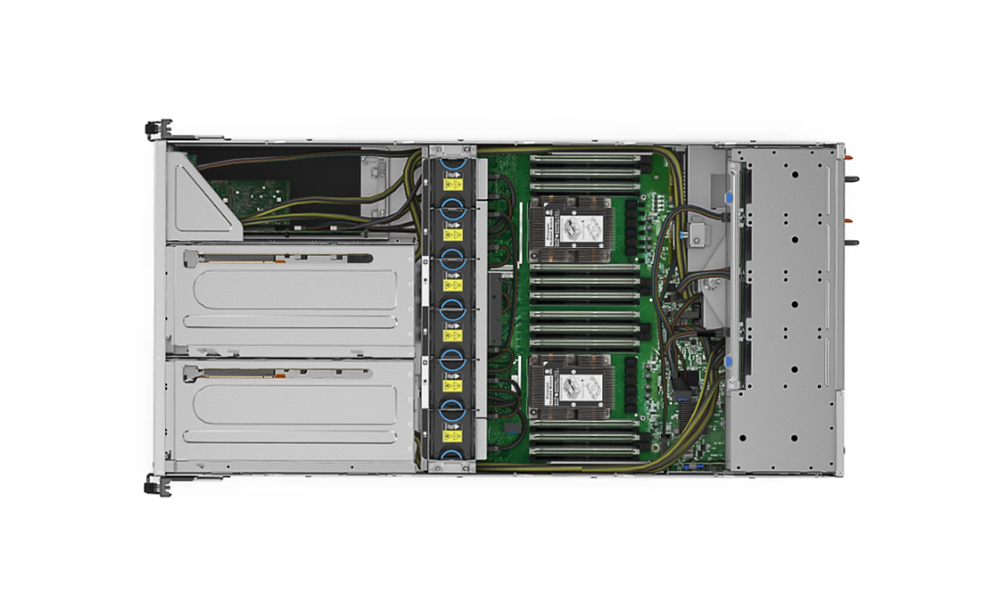

Lenovo ThinkSystem SR670은 인공 지능(AI) 및 고성능 컴퓨팅(HPC)을 위한 최적의 성능을 제공합니다.2U 노드당 최대 4개의 대형 GPU 또는 8개의 소형 GPU를 지원하며 머신 러닝, 딥 러닝 및 추론의 컴퓨팅 집약적인 워크로드 요구 사항에 적합합니다.

최신 Intel 기반®제온®프로세서 Scalable 제품군 CPU를 사용하고 NVIDIA Tesla V100 및 T4를 포함한 고급 GPU를 지원하도록 설계된 ThinkSystem SR670은 AI 및 HPC 워크로드에 최적화된 가속 성능을 제공합니다.

최대 성능

더 많은 워크로드가 가속기의 성능을 활용함에 따라 GPU 밀도에 대한 수요가 증가합니다.소매, 금융 서비스, 에너지 및 의료와 같은 산업은 GPU를 활용하여 ML, DL 및 추론 기술을 활용하여 더 큰 통찰력을 추출하고 혁신을 주도하고 있습니다.

ThinkSystem SR670은 프로덕션 환경에서 가속화된 HPC 및 AI 워크로드를 배포하고 데이터 센터 밀도를 유지하면서 시스템 성능을 극대화하기 위한 최적화된 엔터프라이즈급 솔루션을 제공합니다.

확장 가능한 솔루션

AI로 막 시작하든 프로덕션으로 이동하든 관계없이 솔루션은 조직의 요구 사항에 따라 확장되어야 합니다.

HPC 및 AI를 위한 Lenovo의 강력한 클러스터 관리 플랫폼인 Lenovo Intelligent Computing Orchestration(LiCO)과 함께 작동하는 ThinkSystem SR670은 수요 증가에 따라 확장할 수 있도록 고속 패브릭이 있는 클러스터에서 사용할 수 있습니다.또한 LiCO는 AI 및 HPC 모두에 대한 워크플로를 제공하고 TensorFlow, Caffe를 비롯한 여러 AI 프레임워크를 지원하므로 다양한 워크로드 요구 사항에 대해 단일 클러스터를 활용할 수 있습니다.

기술 사양

| 폼 팩터 | 전체 너비 2U 엔클로저 |

| 프로세서 | 노드당 2x 2세대 Intel® Xeon® 확장 가능 프로세서(최대 205W) |

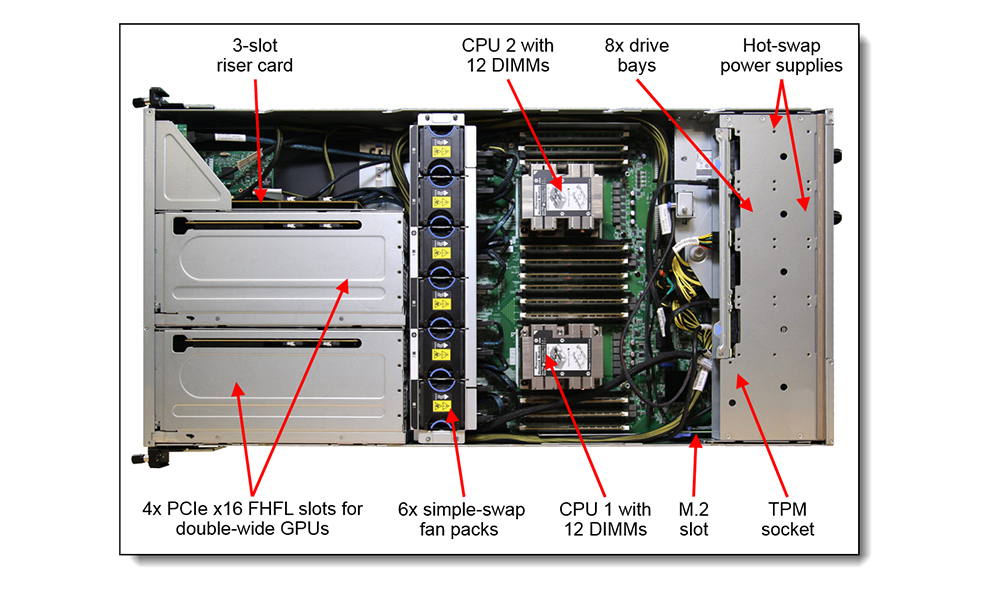

| 메모리 | 노드당 24x 64GB 2933MHz TruDDR4 3DS RDIMM을 사용하여 최대 1.5TB |

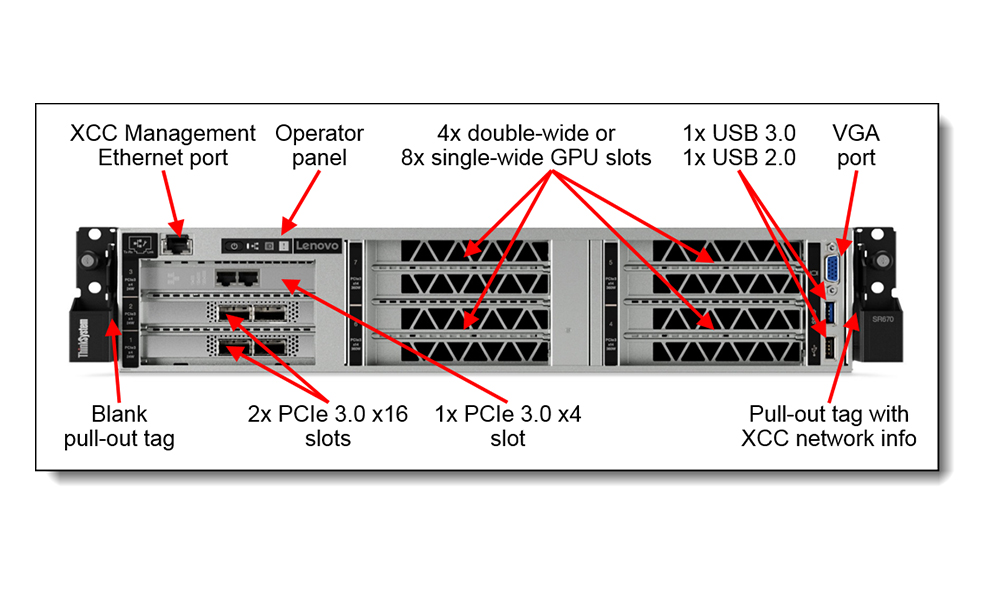

| I/O 확장 | 최대 3개의 PCIe 어댑터: 2x PCIe 3.0 x16 + 1x PCIe 3.0 x4 슬롯 |

| 가속 | 최대 4개의 이중 너비, 전체 높이, 전체 길이 GPU(각 PCIe 3.0 x16 슬롯) 또는 최대 8개의 단일 너비, 전체 높이, 절반 길이 GPU(각 PCIe 3.0 x8 슬롯) |

| 관리 네트워크 인터페이스 | 전용 1GbE 시스템 관리용 RJ-45 1개 |

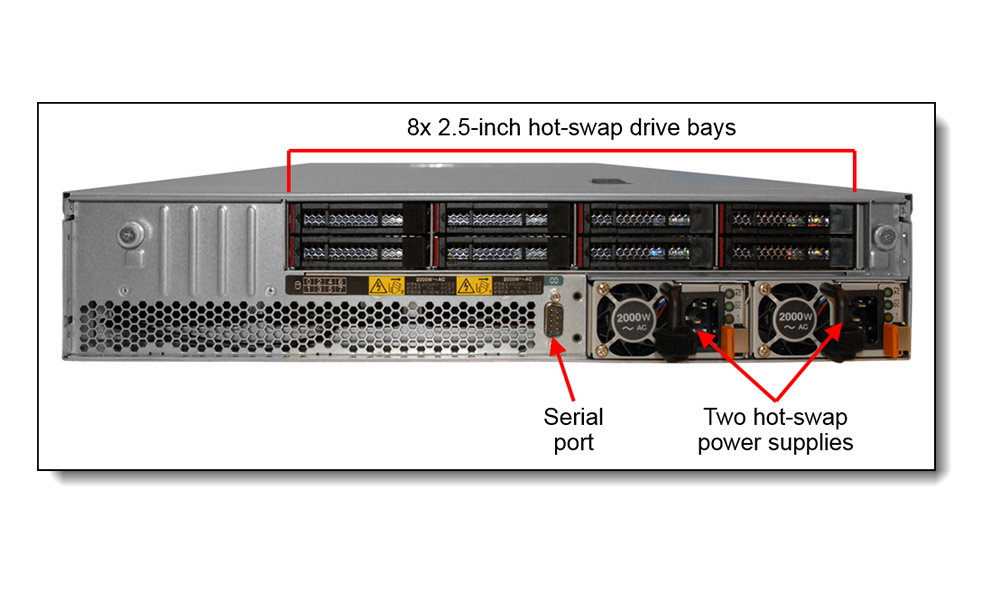

| 내부 저장소 | 후면 베이에 최대 8개의 2.5" 핫스왑 SSD 또는 HDD SATA 드라이브 최대 2개의 비 핫스왑 M.2 SSD, 내부 베이의 6Gbps SATA

|

| RAID 지원 | SW RAID 표준;플래시 캐시가 있는 HBA 또는 HW RAID 옵션 |

| 전원 관리 | xCAT(Extreme Cloud Administration Toolkit)를 통한 랙 수준 전력 제한 및 관리 |

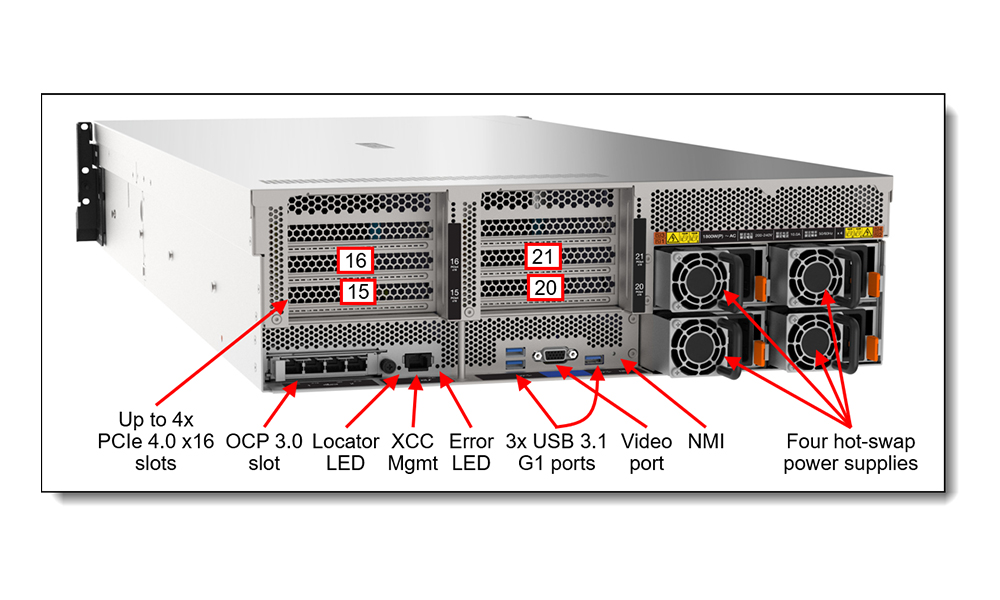

| 시스템 관리 | Lenovo XClarity Controller를 사용한 원격 관리1Gb 전용 관리 NIC |

| OS 지원 | 레드햇 엔터프라이즈 리눅스 7.5;자세한 내용은 lenovopress.com/osig를 방문하십시오. |

| 제한 보증 | 3년 고객 교체 가능 장치 및 현장 제한 보증, 다음 영업일(9x5), 서비스 업그레이드 가능 |

제품 전시